目次

この記事が解決できること

- データ分析を行う際の重要ポイントがわかる

- データの収集・整理を行う手順が分かる

はじめに

前回の記事では、データ分析の2ndステップである「仮説の設定・調査分析の計画」について解説しました。

この記事をまだご覧になっていない方は、当記事を読む前に是非お読みください!

データ分析は、一足飛びにデータの集計を始めても、洞察を得ることができません。しっかりプロセスを踏んで進めていくことが重要です。

今回の記事では、「データの収集・整理」について詳しく解説していきます。

データ分析の流れ

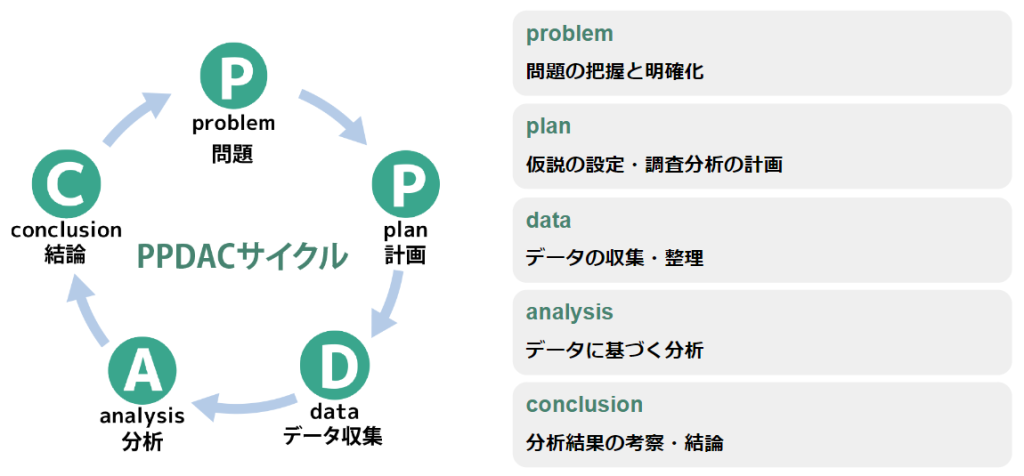

本題に入る前に、データ分析のステップを改めて振り返ってみましょう。

データ分析は闇雲に進めるのではなく、下記のPPDACサイクルを回して実行することがポイントです。

データ分析の流れ

- 問題の把握と明確化 – 分析の出発点となる問題を明確に定義します。

- 仮説の設定・調査分析の計画 – どこに疑問を持ち、どこについて論じるのか現在地を明確にします。

- データの収集と整理 – 分析に必要なデータを収集し、整理します。

- データに基づく分析 – 集めたデータに基づき、仮説を検証し新たな洞察を得ます。

- 分析結果の考察・結論 – 分析結果をもとに、問題の解決策を導き出します。

このサイクルを踏まえて、今回の記事ではテーマ「データの収集・整理」について解説します。

データを収集する

仮説を立てて、いざ分析!の前に大事なステップがあります。それは、自社がもっているデータを把握・整理し、集めたデータを分析できる形に整えることです。

集めたデータはサイロ化しないよう、自社のデータレイクやデータウェアハウスに格納していきましょう。

ひとくちにデータといってもその種類は様々です。そして、データはいくつかの視点から分類することができます。今回は代表的なものをピックアップしてご紹介します。

収集方法によるデータ分類

データは、どんな目的で、誰が、どのような対象に対して収集したものかで分類することができます。企業が独自に収集するプライマリデータと、政府や公的機関が収集・公開しているセカンダリデータに大きく別れ、この二つは相補に補完的な役割を担っています。

- プライマリデータ:企業自らが収集するデータ

- 例:自社サービスのトランザクションデータ、GA4などから取得できる自社サイト内のユーザー行動データ

- セカンダリデータ:政府統計や白書・民間の調査会社などから収集する公的なデータ

- 例:公的統計データ、白書、調査会社のサーベイデータ

データの構造による分類

データをいくつかの基本的なタイプによって分類することも可能です。データ構造のタイプによって、それぞれの特性や扱い方が異なるため、収集・整理を行う前に理解しておくことが重要です。

- 構造化データ:データベースの表形式で保存され、行と列で整理されたデータ。

- 例:スプレッドシート、SQLデータベース

- 半構造化データ:ある程度の構造を持つが、固定のスキーマがないデータ。

- 例:JSON、XMLファイル

- 非構造化データ:明確な構造がなく、整理するのが難しいデータ。

- 例:画像、動画、テキストファイル

データ関連資料も収集の対象になる

データを把握するためのドキュメントには様々なものがあります。テーブル定義書やER図、システムのフロー図などが代表的なものです。

このような資料を、データ収集と同じタイミングで収集しましょう。企業やシステムによっては十分な資料が存在していないことも多くあります。自社の中には存在しているのかどうか、ぜひこの機会に確認してみましょう。

テーブル定義書とER図とは?

- テーブル定義書とは、DB内に存在するテーブルの定義を記載したもののことです。データ型、NULL値を許すか、デフォルト値などの定義が記載されます。

- ER図とは、テーブル同士の関係性を明示した図のことです。特にテーブルが増えて関係が複雑化した時には、このER図を元にテーブル同士の概観を把握します。

さらに詳しく知りたい方はこちらの記事をご覧ください。

データを理解する

次に、収集したデータを正確に、過不足なく理解する必要があります。データの性質やパターンを把握して、効果的な整理や分析を行う準備をしっかりと進めましょう。

データ理解のポイント

データを理解する上で押さえておくべきポイントは下記の4つです。

ポイント

- メタデータの確認

- データの品質チェック

- データの可視化

- データに関連するドキュメントの参照

- メタデータの確認:

データに付随する属性情報を確認します。主にはデータの出所、作成日時、フォーマットなどの理解が必要です。 - データの品質チェック:

データの正確性、一貫性、完全性が保てているかどうかを確認します。このチェックでは、重複データや欠損データの確認、異常値の検出も忘れずに行いましょう。分析に必要なカラムやレコードがそもそもデータテーブルに存在しているかどうかも確認が必要です。 - データの可視化:

統計的手法やグラフを用いて、データの分布や傾向を視覚的に理解していきます。これによりデータのパターンや異常を発見して、後からの手戻りを防ぐことができます。 - データに関連するドキュメントの参照:

テーブル定義書やER図、システムのフロー図など、データがどのように構成されているのかについての資料を元に、データの概要を把握します。自社にそのような資料がないケースは、データ調査と並行してドキュメンテーションを行うと良いでしょう。

データを整理する

最後に、収集したデータをどのように整理し、効果的に管理するかについて説明します。適切な整理は、データ分析や後続の利用をスムーズにします。

ポイント

- データのクレンジング

- データのフォーマット統一

- データの分類とラベリング

- データの保存とバックアップ

- データの保存とバックアップ:

整理されたデータを適切な形式で保存し、定期的にバックアップを取る。データベースやクラウドストレージの活用が効果的。 - データのクレンジング:

データの欠損や異常値を補正・除去し、データの品質を向上。重複データの削除や誤りの修正も含む。 - データのフォーマット統一:

異なる形式のデータを統一し、一貫した形で整理。例えば、日付形式や数値の単位を揃える。 - データの分類とラベリング:

異なるデータセットやカテゴリに応じてデータを分類し、タグ付けを行うことで、必要な情報を迅速に取得可能にする。

データ収集・整理のヒント

データ整理を円滑に進めるためには、関係者間で以下の内容を事前にすり合わせておくことが重要です。

データの目的と使用範囲は明確か?

どのような目標のためにデータ分析を行うのかを、事前にすり合わせておきましょう。

データは誰が、どのようなシーンで、どのような形で利用されるのか(レポート、ダッシュボード、予測モデルなど)の共通認識を握っておくことが重要です。

データの種類とフォーマットは?

データを取り扱う作業者にとって、データの種類やフォーマット、データ内部のカラム定義は非常に重要です。その作業のコストや精度を左右しかねません。

そのため、どのような形式(CSV、JSON、SQLデータベースなど)で提供されるか、各データセットのフィールド(カラム)の定義や、データの粒度(例えば、日単位、時間単位など)などを漏れなく理解しておくことが必要です。

更に、データの定義は扱う部署や人によって異なるものを指すことがよくあります。

たとえば、「優良顧客の分析をする」となった際、「優良顧客」とは毎月買ってくれている人のことなのか?年○円以上買ってくれている人のことなのか?等の定義付けが必要です。

データが手元にある状態では、さらに詳細な情報を確かめていきます。数値、テキスト、日付など、各項目のデータ型が正確に設定されているかも忘れてはいけません。

データクレンジングの基準は?

クレンジングやデータ処理の精度は、分析やモデリングの精度に直結します。欠損データの対応、異常データの処理方法、データの重複やイレギュラーケースが発生した場合の対応ルールなどを定めておきましょう。

データの更新やメンテナンスの方法は?

データを配置するだけでは、常に最新の状態を保つことはできません。そのため、定期的な更新の実行や、定義変更のタイミングでのデータ処理方法の更新、定期的なメンテナンスが必要不可欠です。

データはどの程度の頻度で更新されるか(毎日、毎週、手動更新など)、データの更新やクレンジング、メンテナンスの責任者を明確にしておきましょう。

まとめ

本記事では、データ分析プロセスの3rdステップである「データの収集・整理」に焦点を当て、その進め方を解説しました。

まずテーブル定義書やER図を見てデータの状況を把握することが重要です。資料がない場合は、手順に従い調査をした上で分析に取り掛かりましょう。

次回の記事では、「データに基づく分析」について、さらに深掘りしていきます。お楽しみにお待ちください!

データ活用でお困りの方へ

私たちDX-Accelerator事業では、データ活用についての様々なスキルを持った人材が常駐でデータ活用支援を行うサービスを提供しています。

当事業はローンチから約3年(24年9月時点)ですが、これまでに様々な業界・業種のお客さまのお手伝いをさせていただいております。

少しでも興味を持ってくださったり、すでにご相談をしたいことがある方はお気軽にご相談ください。現在あなたの組織のフェーズがどこにあるかは関係ありません。まずはお話をしましょう。

もう少しサービスについて知りたい方はサービス紹介資料もご用意しています。

お役立ち資料をご活用ください!

データプロフェッショナルであるDXAメンバーが、業務経験をもとにお役立ち資料を作成しています!

おすすめ3選はこちら!

1.GA4 サンプルレポート|Looker Studio 無料プレゼント

GA4の基本KPIが網羅されたテンプレートです!データを差し替えればすぐにご活用いただけます。

2.サンプル経営ダッシュボード | Tableau無料プレゼント

実際にご提供しているダッシュボードをテンプレート化したものです!是非構成やグラフ選択の参考にしてください。

3.データ活用の部長さん必見!データ活用 内製化の正しい進め方

これまでご支援してきた実績をもとに、データ活用の内製化の進め方を解説しています!組織のDXを担われている方、必読です!

以上、おすすめ3選でした!

すべて無料でダウンロードできますので、お気軽にご利用ください。